La ricerca, parte di un accordo di cooperazione scientifico tecnologica Italia-Giappone applicata alla sismicità della California

Un recente studio di OGS e INGV integra un algoritmo di machine learning nell’analisi di sequenze sismiche per valutare la probabilità di forti repliche

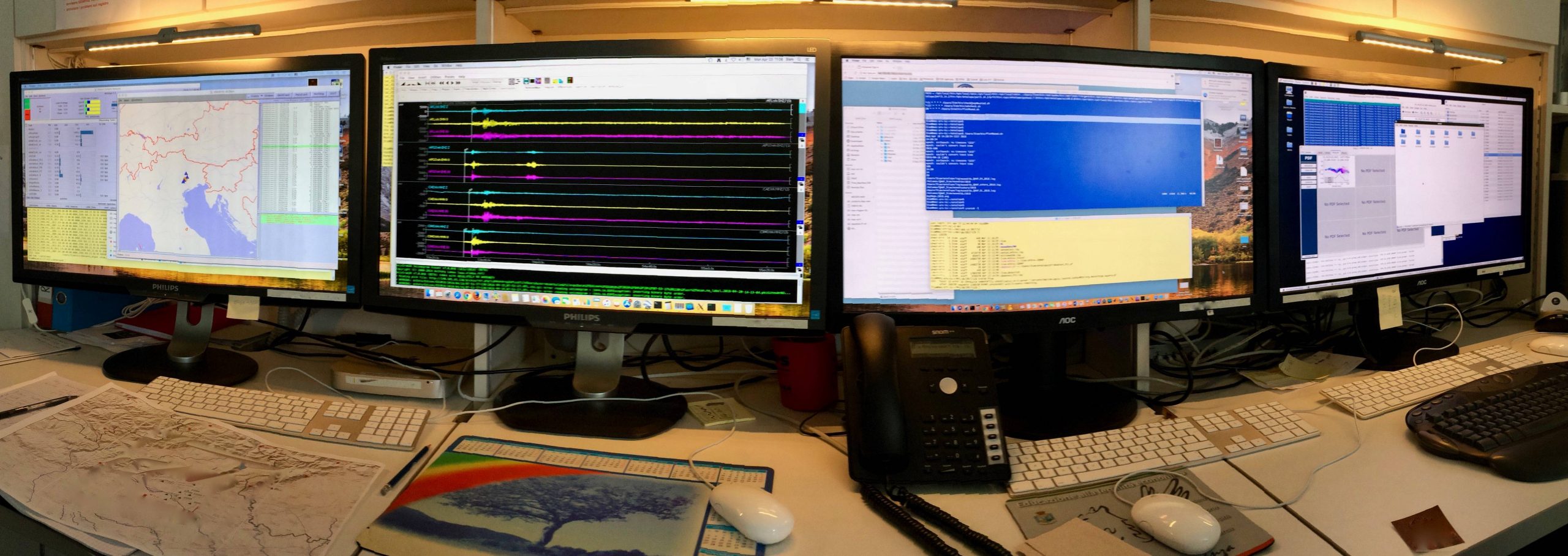

Un algoritmo per la valutazione probabilistica di forti repliche basato su dati e informazioni dei cataloghi sismici della California. È questo il focus del nuovo studio di Stefania Gentili dell’Istituto Nazionale di Oceanografia e di Geofisica Sperimentale – OGS e di Rita Di Giovambattista dell’Istituto Nazionale di Geofisica e Vulcanologia (INGV), recentemente pubblicato su Physics of the Earth and Planetary Interiors.

I terremoti non si verificano in maniera omogenea né nel tempo né nello spazio: una prima scossa sismica particolarmente forte, infatti, è spesso seguita da una serie di repliche successive, anche a distanza di settimane o mesi nella medesima area. A volte può accadere che a una scossa di magnitudo elevata, seguano repliche simili o di magnitudo maggiore: algoritmi di machine learning, una branca dell’intelligenza artificiale, sono stati applicati per valutare la probabilità che un evento di magnitudo superiore a 4 sia seguito da un forte evento.

“Gli algoritmi di machine learning funzionano per apprendimento, e hanno bisogno di una grande quantità di dati per essere addestrati. Quello che abbiamo proposto, chiamato NESTORE, sin dalle prime ore dopo il primo forte evento fornisce indicazioni sulla probabilità che avvengano repliche di intensità simile o maggiore” racconta Stefania Gentili del Centro di Ricerche Sismologiche dell’OGS. “In questo studio, abbiamo utilizzato cataloghi di terremoti avvenuti in California, una zona sismicamente molto attiva e per questo molto ben monitorata e analizzata. NESTORE è stato in grado di prevedere l’accadimento di forti terremoti anche con ampio anticipo nell’ottanta percento dei casi analizzati, con un numero di falsi allarmi inferiore al 20%. Le repliche di magnitudo rilevante possono avere ulteriori impatti su edifici, strutture e infrastrutture già danneggiati dai sismi precedenti e comportare nuovi rischi per la popolazione”, continua la ricercatrice, precisando che “avere possibili indicazioni probabilistiche sul loro accadimento sarebbe estremamente utile”. Per validare statisticamente il metodo e favorirne l’applicazione ad un ampio numero di eventi in diverse aree tettoniche, il software verrà reso disponibile alla comunità scientifica.

Il paper, intitolato Forecasting strong subsequent earthquakes in California clusters by machine learning, è frutto di una lunga ricerca che si inserisce nell’ambito del progetto “Analisi di sequenze sismiche per la previsione di forti repliche”, coordinato dall’Istituto Nazionale di Oceanografia e di Geofisica Sperimentale – OGS, e a cui partecipano l’INGV e l’ente di ricerca giapponese The Institute of Statistical Mathematics (ISM).

Il progetto è inserito nel Protocollo Esecutivo 2021-2023 di cooperazione scientifico-tecnologica bilaterale tra Italia e Giappone e compreso tra gli undici progetti di grande rilevanza ammessi dall’accordo sottoscritto a gennaio dello scorso anno. L’obiettivo è di migliorare le capacità di stimare la probabilità di futuri forti repliche, già a partire da poche ore dopo la prima scossa rilevante, rendendo l’algoritmo sempre più robusto, ovvero addestrandolo affinché fornisca stime di probabilità sempre più affidabili.

Link al paper originale qui